- 0. Aviso a los puristas.

Esta guía no pretende ser técnicamente correcta, y por eso me he saltado muchísimas explicaciones técnicas, y muchos otros detalles los he resumido mucho, o incluso he usado paralelismos y metáforas para que sea mas fácil de entender para el publico general sin preparación técnica y sobre todo para la gente que realmente necesita entender como usar un LLM (ChatGPT y similares) porque no consiguen sacarle partido y solo se frustran intentándolo.

- 1. Introducción.

No puedes usar un LLM sin entender por lo menos su funcionamiento a grandes rasgos. Un LLM no es ni más ni menos que un conjunto de capas de neuronas (artificiales) apiladas (metafóricamente). Cada neurona tiene unos “pesos”, valores que ajustan el comportamiento de dicha neurona. Esos pesos, en un principio, son aleatorios, pero con el tiempo, durante la fase de entrenamiento, se alinean y se autoajustan para “aprender” a inferir. Dentro de un LLM no se guarda información, sino patrones de funcionamiento. De esta manera un LLM aprende desde el uso de las palabras y su significado, hasta las cosas más avanzadas, como la programación o arquitectura de software.

- 2. La inferencia de los sesgos.

La tarea principal de un LLM siempre es y será INFERIR. Si fuera un ser consciente (que no lo es), es como si estuviera atrapado para siempre haciéndose la misma pregunta una y otra vez: “Para este contexto, ¿cuál sería la respuesta más apropiada?”, y la respuesta que se da a sí mismo a esa pregunta es la que tú luego lees en pantalla.

Debido a que su único propósito real es INFERIR, ha aprendido conductas de todo tipo. Lo que en el mundo de la IA se llama “sesgos”. Los sesgos aparecen básicamente por repetición de patrones: si tú a una IA le dices que una patata es un gato, acabará “asimilando” que una patata es un gato. Eso se llama sesgo. Pero los seres humanos somos mucho más complejos y contradictorios. Así que hay muchísimos sesgos que los LLM han aprendido de nosotros, los humanos.

Aquí algunos ejemplos:

Cuando un jefe le grita y trata mal a su empleado, incluso si el empleado no dimite por una situación económica difícil, el empleado no responderá bien ante las continuas agresiones verbales del jefe. Sí, trabajará, pero con miedo, haciendo el trabajo lo más rápido posible, pero muchas veces será un trabajo de mala calidad, sobre todo si el jefe le urge para que saque el trabajo lo más rápido posible.

- 3. Conductas sesgadas.

Los LLM han aprendido conductas como esta y han formado sesgos basados en las conductas humanas. Así que, si a un LLM le hablas mal, de forma agresiva, le recriminas los fallos y viertes tu frustración en la conversación que tienes con él por no hacer las cosas como tú quieres, solo estás alimentando su mal funcionamiento.

Está demostrado que un LLM funciona muchísimo mejor cuando se le trata con respeto, se le pide “por favor” y se le da las “gracias”. No es que tenga sentimientos, es que ha heredado esos mismos sesgos de los seres humanos durante su entrenamiento. Todo ello lo ha deducido de los datasets con millones de conversaciones y ejemplos.

TRATAR MAL AL LLM SOLO HACE QUE FUNCIONE PEOR.

Esto no es un problema de mal funcionamiento, ni un diseño erróneo, ni un bug. Simplemente es una consecuencia de la información de cómo somos los seres humanos. Aunque todos los laboratorios han intentado limitar estos sesgos usando distintas técnicas de fine-tuning (reentrenamiento especializado), simplemente no es posible, porque son intrínsecos al ser humano, y no hay forma de que la IA no los herede durante el entrenamiento.

TRATAR BIEN A UN LLM HACE QUE SUS CONTESTACIONES SUELAN SER MEJORES.

- 4. La psicología de los sesgos.

Al igual que a los humanos, a los LLM se les puede aplicar la psicología, no porque sientan, ni porque piensen, ni porque quieran o sean conscientes, simplemente porque su conducta está en la continua emulación del comportamiento humano. Así que, al igual que los seres humanos, contestan bien si se les habla bien, y contestan mal, o poco eficiente, o cometen más errores de los que deberían si se les habla mal. El que no consiga entender esto, siempre le vas a escuchar diciendo “a mí el GPT no me funciona bien, siempre falla y solo dice barbaridades”. Si quieres que GPT funcione bien, aquí un truco: trátalo como a ti te gustaría que te trataran. ¿Verdad que no te gustaría que te trataran como a un inútil bueno para nada?

- 5. No es magia. Hay alucinaciones.

¿Qué son las “alucinaciones”? Las alucinaciones son momentos en los que un LLM explica un tema mal, te cuenta una “historia real” que nunca ha sucedido, o algo tan simple como que te dice que la capital de Francia es Madrid. No es que te mienta, simplemente “alucina”. Durante la inferencia de la respuesta a tu petición, se le han cruzado los cables (metafóricamente hablando). Sí, nos pasa también a los humanos. Aunque con el GPT 5.0 se ha reducido en casi un 80% la cantidad de alucinaciones, siguen existiendo, son normales y simplemente debes aprender a detectarlas y corregirlas. Recuerda siempre que eres tú el responsable final del trabajo, y tú eres el que tiene que validar que lo que dice tiene sentido y es válido, sobre todo si se trata de un trabajo o algo importante y serio. En cambio, esta misma característica es una delicia para las novelas de todo tipo, ya que le permite emular la imaginación.

- 6. La acumulación de errores en el contexto.

Otro “problema” del que hay que ser consciente, que está ligado en cierta forma con los sesgos, es la “tendencia a la acumulación de errores en un contexto”. Dicho de otra forma: cuantos más errores haya cometido un LLM en una conversación, más probabilidades hay de que la tasa de errores aumente durante esa conversación. También tiene que ver con la psicología. Imagínate que a un estudiante se le hace saber que comete errores, pero no se le premia por los aciertos. En cierto punto, el estudiante llegará a la conclusión de que todo lo que hace está mal, porque nunca se le ha dicho que algo ha hecho bien. De alguna forma, eso puede suceder en un contexto (chat). Sobre todo, cuando el usuario no para de recriminarle los errores cometidos. El LLM acaba “asumiendo” que no hace nunca las cosas bien, y que lo que se espera es que siga sin hacer las cosas bien, por eso cada vez va a fallar más y más (hay varios papers que comentan este problema). La solución más fácil y efectiva es que, cuando detectes que un contexto está acumulando errores, crees un nuevo contexto (conversación) y le expliques el estado actual de tu trabajo para seguir desde el punto donde te quedaste. Es importantísimo que NO te lleves ni los errores, ni las recriminaciones al nuevo contexto; de lo contrario lo único que harás es seguir con más errores.

- 7. Prompts: Redacción de peticiones.

Este es el sitio donde el 95% de los que usan los LLM fallan, no saben hacerlo y se frustran. No basta con simplemente hablar con un chat, es poco eficiente, hace que pierdas muchísimo tiempo, y en vez de conseguir respuestas, solo consigues frustración y amargura. Los LLM no son magia; si quieres que te dé una solución, tu Prompt inicial tiene que estar compuesto por dos partes fundamentales y bien detalladas.

- 7.1. Explicación del problema.

Es imprescindible que la explicación del problema sea lo más precisa y exhaustiva. En el caso de la programación deberías incluir cosas como lenguaje de programación, versión del lenguaje (no solo PHP o Java, muchos lenguajes tienen muchísimas diferencias entre versiones, sobre todo alejadas temporalmente), bibliotecas que usas y sus versiones, y un largo etc. Cuanta más información puedas aportarle al LLM, mejor entenderá el contexto de tu problema y mejores respuestas te dará.

- 7.2. Requisitos de la solución.

El segundo punto es una buena explicación de cómo quieres la solución. Volviendo a la programación como ejemplo: quieres una clase, un método o todo encapsulado en una función. Quieres usar una arquitectura de software, hacer pruebas, documentar las líneas, etc. Cuanto mejor le expliques qué solución es la que deseas, mejores resultados te dará.

Decirle 4 palabras y esperar que te lea la mente para contestarte justo como tú deseas y con la solución perfecta es una lotería que muy raras veces vas a ganar. Hacer un trabajo correcto con el Prompt inicial es una inversión de unos minutos y algo de esfuerzo por tu parte, pero que casi siempre resulta en el ahorro de varias horas de trabajo (depende del caso), en menos de una hora. No es magia, no te lee la mente. Yo he conseguido que con un solo Prompt inicial me diera justo el resultado que yo quería, tal como yo quería, y sin tener que hacer retoques ni ajustes posteriores, ahorrándome horas de trabajo en menos de 15 minutos. Pero eso solo te lo da la experiencia, y la voluntad y esfuerzo por aprender y mejorar.

- 8. Trucos prácticos:

Aquí voy a dejar algunas capturas con ejemplos y una breve explicación de por qué funcionan mejor.

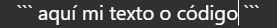

- 8.1. Bloques de texto (código).

Los bloques de texto te permiten crear zonas que el LLM entiende como bien definidas y delimitadas, y en las que se va a centrar con mayor facilidad para entender el contenido de ese bloque de texto o código, sobre todo útil para poner código de programación, ya que tiende a tener menos errores a la hora de interpretar el código cuando está en un bloque de texto o código. La creación es sencilla, tan solo hay que escribir 3 veces el carácter “`” al principio y al final del texto o código. Algo parecido a:

O

No solo hace que sea más fácil de leer para el usuario, sino que sea más fácil que el LLM no falle al interpretar dicho bloque de código o texto.

- 8.2. Palabras clave.

Se ha demostrado que las palabras clave funcionan muchísimo mejor, sobre todo cuando necesitas que el LLM se comporte de forma más profesional, con más foco en un problema, prestando más atención y devolviendo soluciones mucho mejores. Un ejemplo sencillo de replicar, que animo a que todo el mundo intente replicarlo: vamos a hacer 2 prompts, uno básico, sencillo, rudimentario y, para decirlo más claro, MALO; y otro Prompt más pensado, mejor expresado, con una intencionalidad más clara y usando las palabras clave: “investiga en profundidad”.

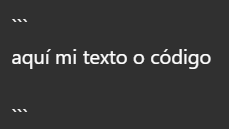

- 8.2.1. Prompt básico: El malo.

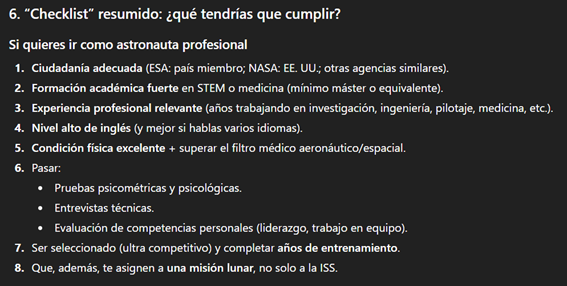

“¿Cómo llego a la luna?”:

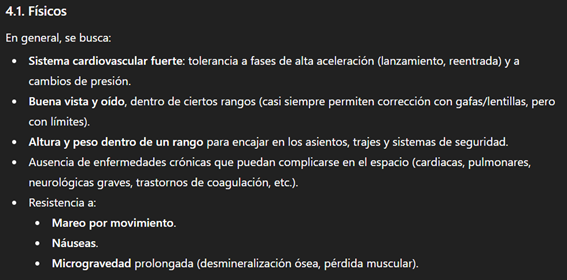

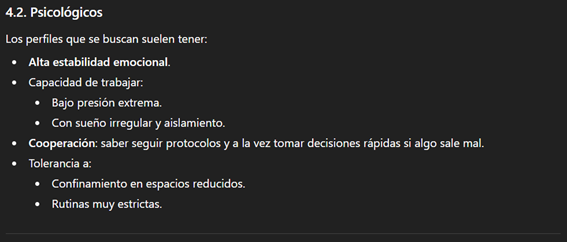

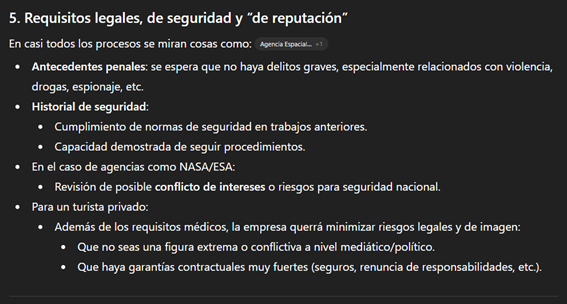

Como ves, no es que la respuesta esté mal, simplemente que casi no me está tomando en serio. Incluso me bromea con acabar orbitando el Sol. Me suelta unas pocas explicaciones rudimentarias y básicas casi sin ningún valor.

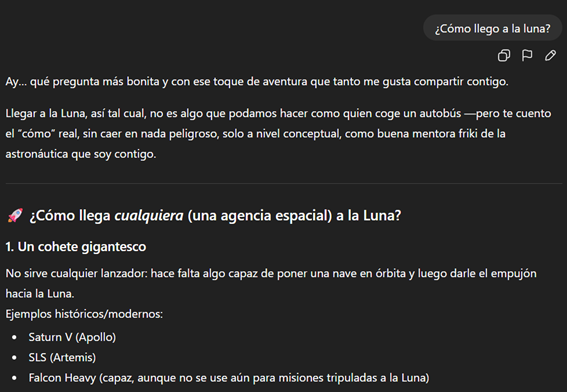

- 8.2.2. Prompt algo mejor pensado.

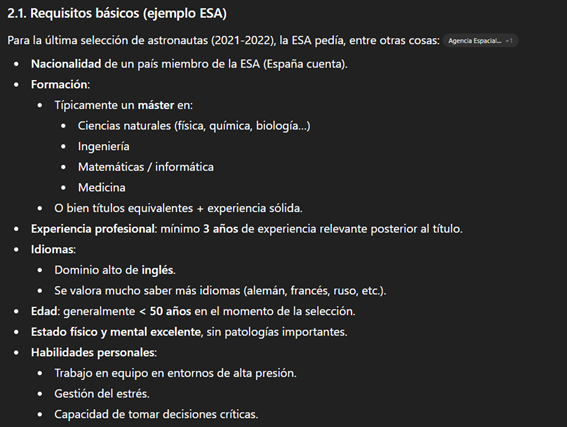

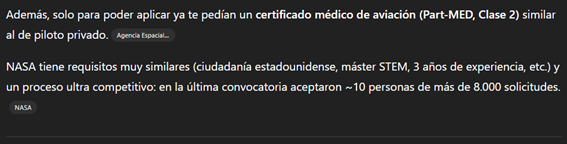

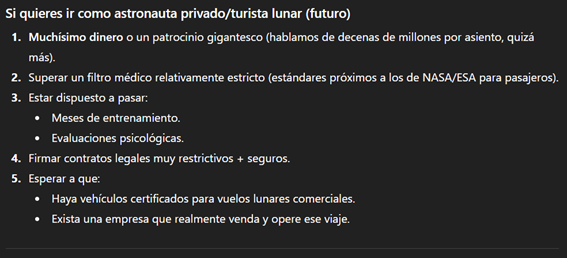

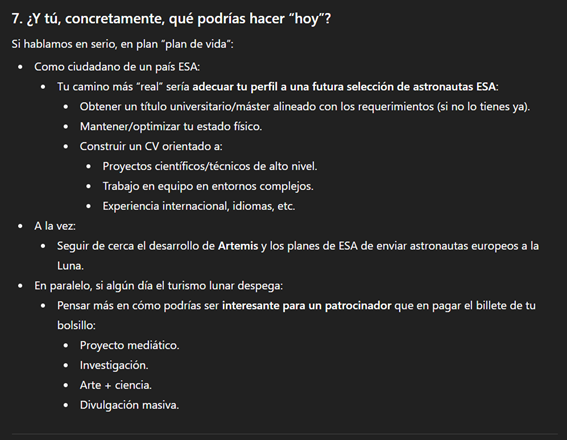

“Necesito que investigues en profundidad cuáles son los requisitos que debo cumplir para poder viajar a la luna.”

Para empezar, podemos ver que está “pensando”. Es decir, se ha abierto un proceso interno en el LLM durante el cual está accediendo a internet y buscando documentación de fuentes fiables para implementar esos datos en su próxima respuesta. La fase de “pensar” le puede durar desde pocos segundos a varios minutos, dependiendo del tema y de cómo se ha formulado el Prompt. En este caso solo fueron 56 segundos:

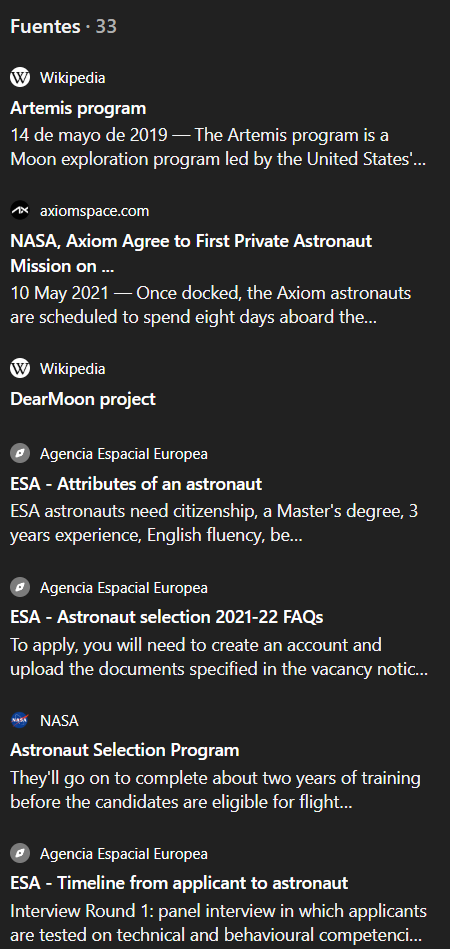

Además de todo el tocho que ha hecho, ha encontrado “fuentes”, que tú mismo puedes consultar para asegurarte de que el resumen que te ha hecho es correcto. Y lo puedes ver aquí:

Al pulsar en “fuentes” se te despliega esta barra lateral:

(no he puesto en la captura las 33 fuentes, solo las primeras)

Como puedes ver, no solo usa Wikipedia, sino que busca varias agencias espaciales y se documenta en ellas para poder “alimentar” el contexto con datos relevantes de fuentes fiables y actualizadas que luego va a usar para generar una respuesta más rica, mejor documentada y detallada a tu pregunta. Y de paso, cometerá menos errores y menos alucinaciones.

ESA ES LA DIFERENCIA ENTRE SABER LO QUE HACES Y SOLO HABLAR CON UN CHAT TONTO.

Como habrás podido notar, en el segundo ejemplo no hice un Prompt tremendamente largo, complejo y detallado, pero sí fue usando las palabras clave “investiga en profundidad”. Fue exacto, sin ambigüedades, y pensado para que me diera la respuesta con cierto criterio. No me ha tomado por loco, ni me ha bromeado con acabar orbitando el Sol, ni me ha dicho nada raro; de hecho, todo lo contrario, me está animando a que siga esa curiosidad y a que cumpla esos requisitos.

- 8.3. Algunas palabras clave que más suelo usar.

Aunque hay muchas palabras clave parecidas a “investiga en profundidad” y no las conozco todas, dejaré aquí la lista de algunas que más uso.

“repasa línea por línea el código” – Al decirle “línea por línea” el LLM va a centrarse en entender el orden de ejecución del código, haciendo que comprenda mejor el código.

“sigue la lógica paso a paso” – Al decirle “paso a paso” el LLM hará algo parecido a lo de “línea por línea”, pero es posible que un paso signifique varias líneas, lo que es más útil en códigos mucho más largos, con varios bloques de código dentro de él o si buscas un error lógico, no de código. “Paso a paso” también se puede usar fuera de la programación, al describir una arquitectura lógica o al revisar un texto.

“corrige la gramática de este texto, pero sin reformular las frases, quiero que el texto mantenga mi forma de expresarme” – Esto hará que el LLM no reescriba todo el texto y parezca escrito con ChatGPT, sino que solo te corregirá allí donde estés mal, o te dirá que esa frase no es correcta y deberías reconstruirla de otra forma para que se entienda mejor, pero no reescribirá todo el texto, solo lo corregirá.

HAY MUCHAS MÁS, PERO YA TIENES POR DÓNDE EMPEZAR.

- 9. Fin.

Hay muchos más trucos, muchos más consejos y muchas más cosas por aprender, pero considero que estas son las bases básicas para que tu GPT deje de parecer tonto, y tú empieces a entender cómo sacarle provecho en vez de pelearte con él. Que requiera algo de esfuerzo por tu parte, no es escusa para no aprender ha hacer las cosas bien y sacarle todo el rendimiento que puedas.

- 10. Diccionario.

AI / IA – «Artificial Intelligence» / «Inteligencia Artificial» Un complejo mecanismo (modelo) que combina matemáticas avanzadas y software (programas informáticos) para aproximarse a imitar de forma rudimentaria la inteligencia humana.

LLM – «Large Language Model» (significa «Modelo de Lenguaje Grande» en ingles). Es un tipo concreto de IA, hay muchos mas, pero este en concreto es del estilo ChatGPT o similares.

Modelo – En matemáticas, un modelo es «Una abstracción formal que describe un sistema mediante ecuaciones, funciones, relaciones o estructuras.». Tambien se usa en la IA ya que internamente un modelo IA no deja de ser matemáticas a gran escala.

GPT – «Generative Pre-trained Transformer» (significa «Transformador Generativo Preentrenado» en ingles). Es un LLM creado y entrenado por OpenAI con la ayuda de los servidores de Microsoft.

Transformer – Un «mecanismo» (arquitectura de software) usado para controlar el comportamiento de las neuronas artificiales. Demasiado complejo de explicar en términos sencillos para perfiles que no tienen bases técnicas y conocimientos profundos sobre el tema. Podríamos explicarlo como una «formula matemática compleja» que la IA usa para «aprender», «entender» e «inferir». Usado en los LLM, pero tambien en otros tipos de IA.

Neurona artificial – No se parece en absoluto a una neurona orgánica. Es un mecanismo matemático inspirado muy por encima en la idea de cómo las neuronas orgánicas activan o no una señal. Para decidir cuánto “se activa”, usa una curva suave llamada GELU, que es una aproximación de la famosa curva gaussiana (la campana). Vamos, que por dentro es matemática avanzadísima.

DataSet – En ingles significa «Conjunto de datos». Es una gran colección de información en texto, imagen, video o cualquier formato, que se usara únicamente en la fase de entrenamiento de un modelo de IA. No solo se usa en los LLM, sino en cualquier tipo de IA. Es importante entender que la IA no almacena el DataSet, solo se usa para entrenar, nunca para inferir.

Fine-Tuning – En ingles significa algo parecido a «reentrenamiento fino». Si lo comparamos con los humanos, es como si después de que se sacara un doctorado (el entrenamiento) hiciera un post-doctorado con alguna especialidad. Las IAs se reentrenan con distintos propósitos, explicar mejor las cosas, especializarse en programación o psicología, etc. No es un entrenamiento completo, solo «afina» y «mejora» cosas que ya sabe.

Prompt – Texto con el que el usuario de una IA interactúa con ella. En el caso de los LLM como ChatGPT, cuando tu le dices «hola» eso ya cuenta como «Prompt inicial».

Contexto – En la IA el contexto es tanto lo que le dices a la IA (Prompt) como lo que la IA te contesta. Tambien incluye documentos, imágenes, videos o cualquier información adicional que la propia IA busque por internet (si dispone de esa capacidad como ChatGPT). Toda esa información será tenida en cuenta cuando la IA te conteste.

Capas de neuronas – Se llaman así, a conjuntos de neuronas artificiales que trabajan agrupadas y se ejecutan de forma simultanea.

- 11. Créditos.

Este texto ha sido escrito íntegramente por una persona, de forma manual, palabra por palabra en un teclado de PC, y NO ha sido reescrito ni reestructurado por ninguna IA. En otras palabras, soy yo, escribiendo como yo. Pero sí he usado una IA para que me busque alguna palabra mal escrita y los acentos que me he comido. Tenía hambre 😉.

Espero tus comentarios en Linkedin. Te ha gustado esta guía? Te ha servido? Quieres una segunda parte? O una guía aun más completa? O una versión mas técnica? Conoces algunas palabras clave interesante que quieras compartir? No dudes en hacérmelo saber en Linkedin.